Marta Lince de Faria

Professora de Fator Humano na Organização e de Microeconomia na AESE Business School, Cátedra de Ética da Empresa e na Sociedade AES /EDP

Ninguém é indiferente ao tema da Inteligência Artificial, precisamente porque parece pôr em causa aquilo que sempre pensámos ser a nossa diferença específica enquanto seres humanos: a inteligência. Se a inteligência humana pode ser replicada e ultrapassada por artefactos, ainda existirá espaço para nós? As maravilhosas descobertas e possibilidades que nos abriu a Inteligência Artificial atraem-nos, mas ao mesmo tempo assustam-nos e geram desconfiança. Não sabemos como acabará tudo isto e as narrativas de ficção científica onde os robôs se revoltam contra os humanos e dominam a terra invadem o nosso imaginário.

Por tudo isto é interessante elencarmos os desafios, mas também as oportunidades éticas relacionadas com a Inteligência Artificial. Se a ética trata da excelência humana e dos caminhos para chegar a ela, pode ser interessante perceber em que medida a Inteligência Artificial nos pode tornar mais humanos ou pôr em perigo a nossa humanidade.

Proponho separar os desafios éticos em três grandes grupos: a) as questões micro têm que ver com ação dos individuais ou a utilização direta da Inteligência Artificial; b) as questões macro têm que ver com as mudanças económicas e sociais provocadas por esta nova tecnologia de uso genérico e, finalmente, c) as questões meta que têm que ver com o modo como compreendemos o que é ser inteligente e em que consiste a moralidade ou “eticidade” dos atos humanos.

A primeira questão micro que se coloca é a da privacidade e da vigilância. A partir do momento em que, por estarmos em rede, os nossos comportamentos são monitorizados e armazenados em bases de dados, há uma grande quantidade de informação pessoal que é gerida para o bem ou para o mal por terceiros. A segunda questão, a manipulação do comportamento, é uma consequência natural da primeira, uma vez que o acesso aos dados cria a possibilidade de se manipular o comportamento das pessoas, como demonstrou o caso Cambridge Analytics. Todos estamos hoje mais expostos a ser manipulados em favor de interesses políticos, de influência ou económicos. A terceira questão micro tem que ver com a opacidade dos sistemas de Inteligência Artificial. De alguma maneira, com estes sistemas “tapamos os olhos” e seguimos as suas recomendações porque é praticamente impossível confirmar todos os algoritmos gerados num sistema de deep learning. Pergunto: é legítimo deixarmo-nos guiar por um sistema opaco ou, levados por um mero pragmatismo, rendemo-nos às grandes facilidades e avanços que nos trouxe a Inteligência Artificial? Gosto de pensar na Inteligência Artificial como no motor de um carro. Na prática os motores dos nossos carros também são opacos para praticamente todos que os utilizam, mas confiamos no profissionalismo e na responsabilidade daqueles que pensaram o sistema pela primeira vez, daqueles que acompanharam as fases de montagem do automóvel e daqueles que são responsáveis pelo controle de qualidade. É razoável utilizarmos um sistema praticamente opaco, mas não seria razoável utilizarmos um sistema teoricamente opaco, porque este sistema seria caótico. A lógica de um sistema praticamente opaco é suscetível de ser analisada e compreendida por alguém que disponha de um número ilimitado de horas, a lógica de um sistema teoricamente opaco nunca poderá ser compreendida porque não existe. Quem esteve na origem da conceção do sistema de deep learning, quem trabalha com ele e olha criticamente para os outputs pode ir identificando anomalias e gerindo a situação do melhor modo possível. A quarta questão é um exemplo das falhas mais comuns identificadas nos sistemas de Inteligência Artificial. O processo de aprendizagem das máquinas faz-se com dados históricos que apresentam os enviesamentos que observamos na realidade: discriminação, tendências históricas, etc. Se a aprendizagem se faz partindo de dados enviesados, os sistemas de Inteligência Artificial não superam as limitações existentes nos dados e na realidade. É preciso sempre um olhar que se pergunte por estas grandes questões.

A robótica, campo concreto dentro da Inteligência Artificia, levanta outras duas questões ao nível micro. Uma questão tem que ver com a interação entre humanos e robôs: um robot pode cuidar de uma pessoa? Um robot pode amar uma pessoa e ser amada por ela? Aqui deixo simplesmente a pergunta para que cada qual pense no significado dos termos cuidar e amar e tire as suas próprias conclusões. Além desta questão, os sistemas autónomos, como os veículos autónomos, levantam outras igualmente interessantes. Os veículos autónomos vão permitir um menor número de acidentes nas estradas, no entanto, surgem os famosos dilemas do trolley (1) tão conhecidos em ética. Os automóveis terão que ser programados para, numa situação limite, optar por salvar uma vida: a do condutor ou a de um pedestre menos protegido, a de um ancião ou a de um jovem adulto. Nestes casos, levanta-se muitas vezes uma lógica utilitarista em relação às vidas: é melhor salvar mais vidas que menos, é melhor salvar uma vida que ainda possa render mais que uma vida que já pouco tem para oferecer… Mas porque é que estes exemplos nos repelem? Ao meu ver, porque nos causa rejeição o facto de termos que avaliar o valor das vidas (durante o COVID muitos médicos falaram do trauma que foi ter que decidir a quem dar ventilador (2) ). Não nos cabe avaliar ou medir o valor das vidas. A meu ver, esta questão deveria resolver-se do seguinte modo: a condução autónoma em geral permitirá salvar um grande número de vidas, o que é uma melhoria ética considerável. No entanto, processos que antes não eram objeto de decisões conscientes porque o condutor simplesmente reagia como podia, passam com a condução autónoma a ser objeto de decisão. Como não podemos atribuir um valor à vida de cada pessoa, parece-me que o melhor é afirmar que todas valem o mesmo e deveremos programar os automóveis para que, nestas situações, atuem de acordo com uma variável aleatória que atribua o mesmo peso a todas as vidas.

As mudanças económicas e sociais geradas pelos sistemas de Inteligência Artificial não são menos interessantes. A primeira grande questão macro é a automação e o emprego. Esta questão não é nova, já se levantou na revolução industrial e outras revoluções tecnológicas pelas quais passou a humanidade. Alguns economistas explicam que apesar de parecer, à primeira vista, que esta revolução tecnológica vai destruir postos de trabalho, acabará por criar muitos outros que neste momento não poderiam ser sequer imaginados. Os agricultores que viveram a revolução industrial perderam muitos dos seus postos de trabalho, mas criaram-se realidades e empregos novos em restaurantes, ginásios, salões de beleza, etc. Nesse sentido, os sectores que poderão crescer mais são os relacionados com a saúde e o bem-estar e com a ocupação do maior tempo livre das pessoas (educação, arte, turismo, etc.). Por este motivo, a Inteligência Artificial é uma oportunidade ética que permitirá que mais pessoas se dediquem a atividades mais propriamente humanas do que trabalhos repetitivos ou com pouco contacto humano. Tudo isto não exclui que uma geração já não tenha capacidade para se requalificar e recolocar no mercado de trabalho: será necessário criar safety nets para estas pessoas.

Existem, no entanto, ainda três grandes questões quando pensamos no desenvolver dos sistemas de Inteligência Artificial baseados sobretudo em grandes bases de dados. Por um lado, está o grande poder económico e de influência que se concentra nas empresas de tecnologia mais importantes (por exemplo as GAFAM), por outro lado, está o aumento das desigualdades porque estas tecnologias causarão o desaparecimento dos postos de trabalho medianamente qualificados, concentrando a procura de mão de obra nos extremos da qualificação, e finalmente o equilíbrio delicado entre privacy e crescimento económico. Os países menos respeitosos da privacidade terão acesso a oportunidades de crescimentos maiores porque todo o potencial da Inteligência Artificial, como a desenvolvemos atualmente, reside nos dados.

As questões meta têm essencialmente que ver com três perguntas. a) Reproduzindo o cérebro humano (ou as redes neuronais do cérebro) como causa material da inteligência humana, reproduz-se a mente humana? b) A inteligência humana só processa dados? c) A Inteligência Artificial pode ser um sujeito moral?

Estas questões são estritamente filosóficas e a resposta das três implica pensar um pouco sobre a inteligência natural. Quando falamos de Inteligência Artificial falamos de sistemas que tentam reproduzir os resultados do pensamento e da ação humana, mas faltar-lhes-á alguma parte fundamental? Um sistema de Inteligência Artificial simula as conexões neuronais que existem no cérebro humano, processa os dados com mais eficiência que um ser humano, mas não replica o modo através do qual o ser humano conhece e interage com a realidade. Um sistema de Inteligência Artificial itera e melhora o seu próprio algoritmo segundo os resultados encontrados, mas não é capaz de ler dentro das coisas – inte-legere–, processa na superfície embora processe com eficácia, mas não penetra na interioridade das coisas. A experiência do conhecimento é alheia a um mecanismo de Inteligência Artificial. Talvez isto nos leve a concluir sem preconceitos e sem esoterismos que pode haver qualquer coisa em nós que não seja puramente material, uma potência com uma flexibilidade que permita ler dentro – inte-legere – da realidade sem lhe fazer violência. A inteligência humana não se limita a processar a realidade, mas toca-a de uma maneira diferente. Na Grécia Antiga e depois na época medieval distinguiam-se dois atos da inteligência humana: a razão e o intelecto. A razão é o movimento próprio da inteligência humana que necessita de se “movimentar” por conhecer através da realidade material. No entanto, o intelecto é o descanso e fim da inteligência quando repousa na consideração de algo que tem diante de si, acontece quando procurando conhecer algo chegamos a dizer: “Eureka!”.

Esta é talvez a melhor oportunidade ética oferecida pela Inteligência Artificial: a possibilidade de voltarmos a compreender o que é especificamente humano e que nos constitui como seres com um lugar especial no universo. Reproduzir os sistemas neuronais cerebrais não é suficiente para reproduzir a função de inte-legere a realidade, porque esta função não pode ser reproduzida por elementos meramente materiais (será assim que seremos capazes de descobrir o que é uma potencial espiritual?). A inteligência humana não é (só) um processador ou uma calculadora: não tem apenas uma componente de razão de movimento, mas tem uma componente de quietude e apreensão da realidade. E finalmente a Inteligência Artificial não pode ser sujeita de moralidade porque isso implica uma capacidade intelectiva real e o primeiro princípio da razão prática: faz o bem e evita o mal.

Por muito que nos maravilhe ou surpreenda os sistemas de Inteligência Artificial não devem despertar medo ou desconfiança, devem sim despertar um bom sentido de responsabilidade. A Inteligência Artificial nunca poderá chegar a reproduzir o que é especificamente humano embora possa e deva ser um instrumento que AMPLIE muito todas as suas possibilidades.

(1) Ver The trolley problem, Philippa Foot, 1967.

(2) Ver: Traumatic Stress in Healthcare Workers During COVID-19 Pandemic: A Review of the Immediate Impact em https://www.frontiersin.org/articles/10.3389/fpsyg.2020.569935/full

Equacionar o futuro

Maria de Fátima Carioca

Professora de Fator Humano na Organização e Dean da AESE Business School

La configuración institucional de las Empresas Familiares

Carlos Folle

Professor de Gestão de Negócios, Política e Gestão de Empresas pela Family Business IEEM, School of Business da Universidade de Montevidéu, Uruguai e da AESE Business School

How science fiction predicted recent high-tech developments in chemistry

Mark Lorch

Professor of Science Communication and Chemistry, University of Hull, The Conversation

Image: Matej Kastelic/Shutterstock

How skills-based organizations can use AI to create the jobs of tomorrow

Aneel Bhusri

Co-CEO, Co-Founder and Chair, Workday, World Economic Forum

Image: Photo by ThisisEngineering RAEng on Unsplash

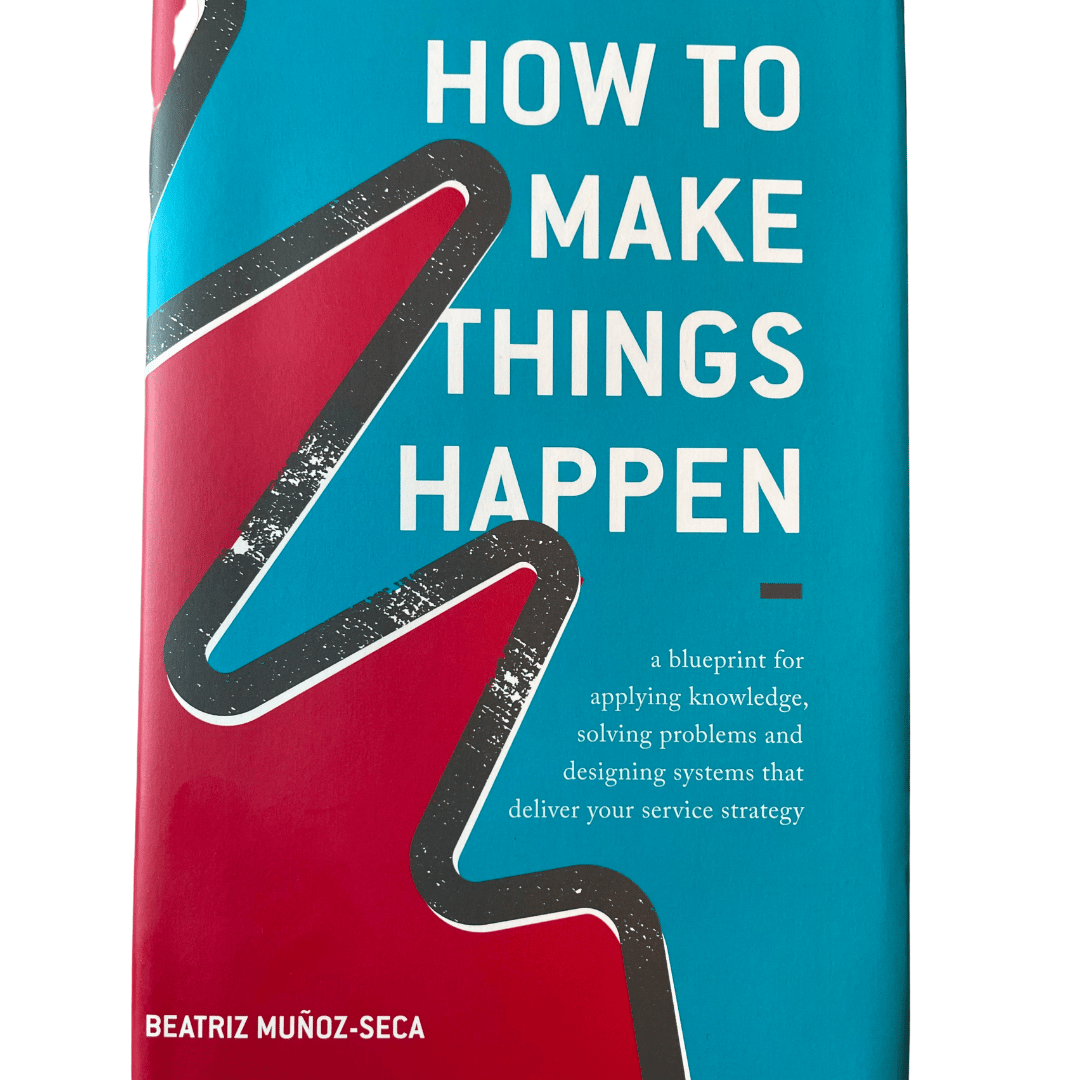

How to make things happen, Beatriz Muñoz-Seca

“If you don’t get it, I will (*): One of the pillars in “To manage is to serve,” which consists of giving agents freedom but staying ready to help whenever needed.”